a = torch.ones((2, 2), requires_grad=True).to(device) b = a.sum() b.backward() print(a.grad)

修改后的代碼為:

a = torch.ones((2, 2), requires_grad=True) c = a.to(device) b = c.sum() b.backward() print(a.grad)

類似錯誤:

self.miu = torch.nn.Parameter(torch.ones(self.dimensional)) * 0.01

應該為

self.miu = torch.nn.Parameter(torch.ones(self.dimensional) * 0.01)

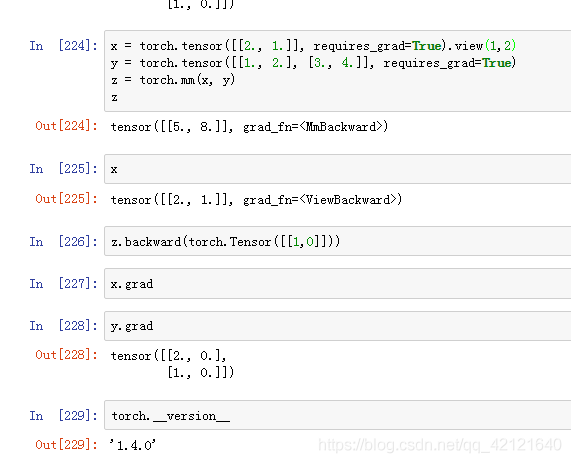

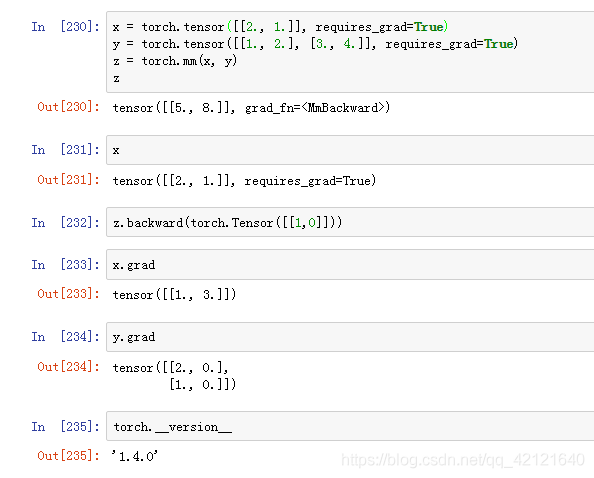

補充:pytorch梯度返回none的bug

tensor即使設置了requires_grad,反向傳播之后, x返回沒有grad梯度,為none

不知道其他版本有無此bug

補充:PyTorch中梯度反向傳播的注意點

optimizer.zero_grad()語句的位置比較隨意,只要放在loss.backward()前面即可,它的作用是將梯度歸零,否則會在每一個迭代中進行累加,

loss.backward()的作用是反向傳播,計算梯度,optimizer.step()的功能是優化器自動完成參數的更新。

optimizer.zero_grad() loss.backward() optimizer.step()

以上為個人經驗,希望能給大家一個參考,也希望大家多多支持腳本之家。